第14章 科学2 実験と統計

要約

ここでは大量の実験から得られた実験データを処理し、帰納的推論によって法則を見つけるために必要な統計処理について解説する。統計処理の中で最も単純かつ強力な平均とデータの平均の周りのばらつき具合を表す分散、データのばらつき加減そのものを考察対象にする分布という概念について説明し、それらを実際の実験データに適用し落体の法則やアクセスランキングの法則、収穫加速の法則などを発見していく。

14.1 統計

14.1.1 平均

データを平らに均す

実験によって正確な科学法則を見つけるには何度も何度も同じ実験を繰り返し、確かにこの原因にこの結果が対応するという確信を得る必要がある。 実験は結果を数値にして扱うことがある。 現象を数値にするには、その現象の中に実数の構造と同じ構造を持った性質を見つける必要がある。 そしてほとんどの場合それは可能である。 この実験結果を表す数を実験データとか単にデータと呼ぶ。 つまり、実験によって科学法則を見つけるには、大量の実験データを扱う必要がある。 統計とはその大量の実験データから有意義な情報を取り出す手法である。

数ある統計の手法の中で最も簡単で便利なものが平均を取るという手法である。 平均とは平らで均一にするということで、ばらつきのあるデータの、飛び出た部分を削りへこんだ部分を埋め合わせるのに使って全体をならすことである。 平均を取るには今あるデータを全て足し、それをデータの数で割ればいい。

例えばここに5人の人が居たとして、その年齢が38歳、39歳、39歳、41歳、43歳だったら、平均は40歳になる。

(38+39+39+41+43)/5=200/5

=40

ということである。 平均はそのデータの集まりの中心がどこにあるのかを教えてくれる。 5人の中に40歳の人は一人も居ないのだが、5人の年の中心がどこにあるのかを計算したら40歳になるということである。 年齢はその人の体力や健康状態や嗜好を見積もるときの目安にできるので、ある団体についてそれらの要素の平均の見積もりを考えるとき、平均年齢は重要な意味を持つ。

実験データから科学法則を見つける場合、大量の実験データが必要になるが、そのデータは全て同じ値になることはなく、ある程度の傾向はあれどばらついた値になる。 実験は常に同じ状況を再現して行うが、完全に同じ状況を再現することはできないので、モデルで許容している範囲の違いはどうしてもある。 この用意した状況のわずかな違いが実験結果のわずかな違いを生む。 だから実験データの値はばらつくのである。

これらのデータのばらつきは実験の状況を完全に同じにすることができないために生まれる。 そして実験で実際に用意された状況は、実験で再現しようとしている状況の周辺にばらつく。 ならば実験データは実験で再現しようとしている状況を完全に再現できたときに得られるデータの周辺にばらつくはずである。 つまりばらついた実験データの中心を求めるために平均を計算すれば、本来欲しいデータに近い値になるはずなのである。 このようにして本来欲しい状況を実験で再現できなくとも、本来欲しい実験データを手に入れることができる。

例えば色々な種類の紙飛行機を作って、どれが一番よく飛ぶかを調べたとする。 投げ方はできるだけ同じになるようにして、それぞれの紙飛行機を何度も何度も飛ばして飛んだ距離を測ったとする。 そうして、次のような実験データを得たとする。

| 種類 | 1回目 | 2回目 | 3回目 | 4回目 | 5回目 | 平均 |

|---|---|---|---|---|---|---|

| 種類その1 | 3.10 | 3.25 | 3.00 | 3.15 | 3.05 | 3.11 |

| 種類その2 | 3.50 | 3.45 | 3.55 | 3.47 | 3.53 | 3.50 |

| 種類その3 | 4.10 | 4.00 | 4.30 | 4.15 | 4.20 | 4.15 |

それぞれ、飛ばしてみるたびに飛んだ距離はちょっとずつずれている。 風の影響だったり、同じように投げたとしてもどうしても微妙なずれがあるはずなので、実験データはばらつく。 このデータから、この種類の紙飛行機はこれだけの距離を飛ぶ能力がある、という結論を得たい。 しかし、データは飛ばしてみるごとにばらばらなのだから、どのデータをそれぞれの紙飛行機が飛べる距離とすればいいのか分からない。

このような場合に計算するのが平均である。 平均を計算してみると、種類その1の紙飛行機の平均の飛んだ距離は3.11mで、種類その2は3.50mで、種類その3は4.15mとなる。 この平均の値をそれぞれの紙飛行機の飛べる距離とすれば、ばらばらなデータの中から一つを選んだりするよりもは正しい数になっていると期待できる。 これは、種類その1の紙飛行機を投げれば大体3.11m飛ぶし、種類その3なら大体4.15m飛ぶという意味である。 結果はばらつくだろうが、大体を考えればその数に近い距離になるという意味である。 ちなみに平均を考えれば種類その3の紙飛行機が最も遠くまで飛ぶ能力を持っていることが分かる。

このようにばらついた実験データでも平均を計算することで実用的なデータになり得る。 しかし平均だけではデータから正しい情報を引き出せないこともある。

例えばここに6人の人が居たとして、その年齢が19歳、20歳、21歳、57歳、61歳、62歳だったとする。 この6人の年齢を平均すると40歳になるのだが、6人の中に誰も40歳に近い年の人は居ない。 にもかかわらず平均は40歳になる。 もしもこの6人の集団の特徴を40歳という平均の年齢だけで見積もったら、実際とはかけ離れた見積もりをしてしまうことになる。 この6人はむしろ、平均年齢20歳の3人と平均年齢60歳の3人の集団が合わさったものだと考えるべきである。 同じように、もしも実験データのばらつきが2つの中心を持つようになっていた場合、それを単純に平均しただけでは正しい実験データを得ることができないことがある。

14.1.2 分散

どの程度不確かかを確かめる

平均だけではデータの特徴を完全には理解できないことが分かった。 それはたとえ平均が同じでも元のデータのばらつきが違えば集団としての性質が変わるからである。 例えば平均より1だけ大きいデータと1だけ小さいデータの集まりと、平均より10だけ大きいデータと10だけ小さいデータの集まりでは明らかに違う。 その違いを明らかにするために分散という概念がある。

分散とは個々の実験データとその平均の引き算を計算し、その結果を2乗したものの平均を計算したものである。 これは実験データと平均の違いの大きさの目安という意味を持つ。 実験データと平均の引き算をすれば、その実験データが平均からどれだけずれているかが分かる。 例えば平均が40歳なら42歳の人は平均から2歳ずれているし、50歳なら10歳ずれているのが分かる。 しかし、実験データから平均を引いたら負の数になってしまう場合がある。 例えば平均が40歳なら38歳の人は平均から−2歳ずれているということになる。 今問題にしているのは平均からのずれなので、正の数のずれも負の数のずれも同じように扱わないといけない。

そのために実験データと平均の引き算の結果を2乗する。 正の数も負の数も2乗すればどちらも正の数になる。 その数が大きければ大きいほど、そのデータは平均から離れているのが分かる。 そしてその平均を計算すれば、そのデータの集団全体がどれだけ平均から離れているのかが分かる。 ちなみに2乗しないで平均とのずれを全て足せば0になる。 当たり前だが、平均というのはその集団のちょうど中間のことなのだから、その前後にデータが散らばっているのであり、平均とデータの差の大きさは前後で一致しそれぞれ正と負の数になるので、平均すれば打ち消しあって0になる。

では実際に平均が同じ2つのデータの分散を計算してみる。年齢が38歳、39歳、39歳、41歳、43歳の5人の集団と19歳、20歳、21歳、57歳、61歳、62歳の6人の集団の分散を計算する。平均は前もって計算しておいた通り、40歳である。そうなると分散はそれぞれ、

[(38-40)2+(39-40)2+(39-40)2+(41-40)2+(43-40)2]/5=[(-2)2+(-1)2+(-1)2+12+32]/5

=[4+1+1+4+9]/5

=19/5

=3.8

[(19-40)2+(20-40)2+(21-40)2+(57-40)2+(61-40)2+(62-40)2]/6=[(-21)2+(-20)2+(-19)2+172+212+222]/6

=[441+400+361+289+441+484]/6

=2416/6

=402.666...

となる。平均だけ見ると同じように見える集団も分散を計算すればまったく性質の違う集団であることが分かる。 また、分散は実験データが平均の周りにどれだけ散らばっているかを表しているので、それが小さいほど平均の周りにデータが集中していることを示し、実験の精度が良いということになる。 ある実験データの分散を計算し、それが大きすぎる場合はその平均が実験モデルの本来のデータを表しているとは考えにくく、実験をやり直すなりモデルを作りなおすなりしなければならない。

14.1.3 分布

個性の統計

このように、ある実験データの集まりには平均と分散という概念がある。 これは本来欲しいデータの周囲に実験データが散らばってしまうために、どうしてもばらばらな数になってしまうデータから分かりやすい意味を探り出すために必要な概念である。 ここには本当ならデータはばらついて欲しくないが実際は理想通りにはいかずばらついてしまうという、後ろ向きの考え方が潜んでいる。 しかし、データは本来ばらつくものだと認め、それがどのようにばらつくのかを調べ、そのばらつき方に意味を見つけようという前向きの考え方をすることもできる。 その前向きの考え方が分布という概念である。

実験データは必ずばらつく。 そのばらつき具合を分布と呼ぶ。 例えば、ここに2つの実験データの集まりがあるとする。

データ集1:10,12,14,13,11,12,15,13,13,12,14,11,13

データ集2:17,14,15,12,16,14,15,16,13,14,15,13,15

データ集1もデータ集2も10から17までの2桁の数が13個ずつ並んでいる。 これはただの数字でもいいが、例えばデータ集1は適当に街を歩いていた30歳以下20歳以上の若者に協力してもらい先月何冊の本(漫画含む)を読んだか答えてもらい、データ集2は40歳以上50歳以下の中年に答えてもらったデータだという様に意味を持たせることができる。 ぱっと見た感じではデータ集1の方がデータ集2よりも数字が小さいように見える。 データ集1にでてくる最大の数は15で16は出てこないからである。 そうは言っても多くの数が2つのデータ集でかぶっていて、本当に差があるのかどうか自信が持てない。

こういう時に計算するのが平均と分散である。 平均と分散を計算すると、データ集1の平均は12.54、分散は1.66に、データ集2の平均は14.54、分散は1.66になる。 これを見ると、データ集1とデータ集2との間に明らかな違いがあることが分かる。 データ集1の方が平均が小さいのだから、集団として全体的に見ればデータ集2より数が小さいことになる。 分散がほぼ同じ数になっているので、このデータ集はそれなりに信頼のおけるデータ集で、データの偶然のばらつきのせいで平均がずれたという心配はなさそうである。 もしこのデータ集に先ほど付けたような意味があるとすると、若者の方が本を読んでいないことが分かる。 つまり若者は月に平均12.54冊の本を読んでいて、中年は14.54冊の本を読んでいる、ということになる。

しかし、ここで言う平均には今まで言っていたのとは少し違う意味を持っている。 今平均したのは人々の読んでいる本の数である。 もちろん、標準的な人の読む本の数、というものはあるだろうが、基本的に誰がどれだけの冊数の本を読もうが自由であり、そのデータを集めたらばらばらになるのが当然である。 つまり、今までは理想的な状況ではデータはほとんど同じ数になるべきだということだったが、今の場合は理想的な場合にこそデータはばらばらになるのである。 毎月読む本の数がすべての人で同じ、というのは何か不自然で不自由な社会構造の下での生活を余儀なくされている状態を示唆する。 それはあまり理想的な状態とは言えない。 つまり、このようなデータは必然的にばらばらに分布する。

そういう意味で、このデータの平均や分散にはあまり意味がない。 しかしこのデータがどのように分布しているかを調べて、2つのデータの集まりの分布の違いを見つけることができる。 データの分布の仕方に違いがあれば、それは2つのデータ集が違った特徴を持っているということができる。 そのために、ひとまずそれぞれのデータ集の中の数を小さい順に並べ替えてみる。

データ集1:10,11,11,12,12,12,13,13,13,13,14,14,15

データ集2:12,13,13,14,14,14,15,15,15,15,16,16,17

こうすればだいぶデータが見やすくなる。 ぱっと見た感じでもデータ集2の方が14や15のような大きな数が多く出てくることが分かる。 もっと見やすくするために、どの数が何回出てくるかを数えてみる。

データ集1:10,1回、11,2回、12,3回、13,4回、14,2回、15,1回、16,0回、17,0回

データ集2:10,0回、11,0回、12,1回、13,2回、14,3回、15,4回、16,2回、17,1回

このようにどの数が何回出てくるのかを書き出せば、データ集ごとの数の分布がよく分かるようになる。 これによれば、データ集1の中で一番多いのは13で、そこから離れるにしたがって回数が減り、データ集2の中で多いのは15で、そこから離れるにしたがって回数が減っていることが分かる。 明らかに2つのデータ集の中で数の分布の仕方が違う。 このようにすればデータの分布を調べることができるが、まだこれでは直感的な広がりやばらばらな感じが分からない。 直感的な感覚を得るためにグラフを使う。 このグラフのことを度数分布図とかヒストグラムと呼ぶ。

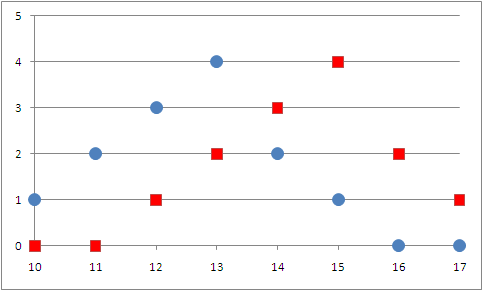

図1 ヒストグラム

データ集1を青丸で、データ集2を赤い四角で表している。

このグラフは横軸にデータ自体の数、縦軸にその数がデータ集の中に何回出てくるかを表している。 例えばデータ集1には13が4回出てくるので横軸で13のところに4の高さに青い丸がついている。 このグラフを見ればデータ集1とデータ集2の違いが一目で分かる。 データ集1は13が一番高い山のような形の分布をしており、データ集2は15が一番高い山のような形に分布している。 それぞれ13と15を中心に両脇に広がるように分布しているのが分かる。 全体的に見て、お互いに多くの部分が重なっているのが分かるが、分布の仕方はずれているのが分かる。 つまり、この2つのデータの集まりは違った性質を持っているのが分かる。

このように、あるデータの集まりがあった時、そのデータの分布の仕方をみることで、その集団の全体の性質を理解できる。 そのデータは、先月読んだ本の冊数だったり、平均の運動時間、身長、体重、などといった、人によってばらばらで当然のデータであってもいい。 そのような、人によって違うのが当たり前のデータであっても、分布を見ることによってその集団の全体の性質を見ることができる。 よく、「最近の若者はこれだからけしからん」などといった主張をする年配がいて、「一口に若者といっても色々な人がいるのだから一概には言えない」と若者が言い返す展開があるが、このように実際にデータを集め、その分布を見れば確かに集団としての傾向を見ることができる。 逆に言えばこのようなデータ抜きにある集団の性質を議論するのは無意味な行為である。

このように、あるデータの分布を見ることで、集団の性質の違いを見ることができる。 重要なのは、個々の個人を取ればその中には様々な人がいて、標準的な性質を持った人はあまり居ないということである。 にもかかわらず、データを数多く集めて集団として分布を見れば、その分布には明らかに集団の特徴が出ることがある。 この集団の特徴は確かにその集団に対して当てはまる特徴である。

正規分布

このようにデータの分布というのはとても重要な性質である。 これまでは個人的な趣味嗜好のような、分布するのが当たり前のデータについての分布を見てきた。 しかし、データの分布という考え方はそのようなデータに限らず、あらゆるデータに当てはまる。 これからは元に戻って、できれば分布して欲しくない実験データの分布について説明していく。

実験データは実験がうまく行われていれば、平均値の周辺に最も多くのデータが集まり、そこから離れていくにしたがってデータの数が減っていくという、釣鐘型の分布をする。 これは実験がうまく行われていれば、平均値がその実験のモデルの本来のデータであり、そこからどうしても無くせない実験の誤差によってデータがずれるのだから、当然平均値の周りの数をデータとして得る場合が最も多くなり、そこから大きくはずれる場合はあまり起こらないためである。 データの数が少ない場合はいびつな分布になるかもしれないが、データの数をどんどん多くしていくと、それはある一定の分布を持つようになる。 この分布を正規分布とかガウス分布と呼ぶ。

ガウス分布とは次の式によって表される分布である。データをx、データの平均をμ、データの分散をσ2と表すと、

f(x)=1/(√2π・σ)・e-(x-μ)2/2σ2

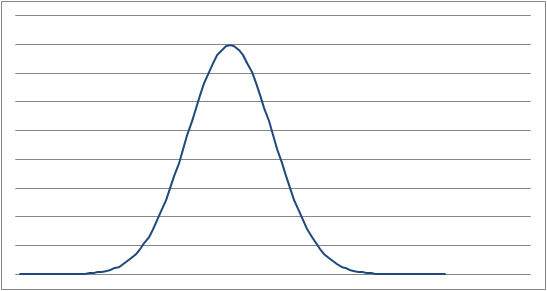

となる。少し見にくいが、これは自然対数の底に指数として-(x-μ)2/2σ2という少し複雑な関数を持ち、それに1/(√2π・σ)という係数を掛けたものである。 分かりにくくて申し訳ないが、分母は√2π、つまり2πの平方根とσを掛け算したものである。 σ2が分散なので、σは分散の正の平方根ということになる。 -(x-μ)2/2σ2の部分は、x-μはあるデータの平均からのずれを表し、(x-μ)2はそれを2乗しているのだから常に正の数になる。 そしてそれを分散の2倍の数で割り、負の符号をつけて指数の肩に乗せることになる。 (x-μ)2はそのデータの数が平均からずれればずれるほど大きくなり、指数の肩に負の符号をつけて乗せるのだから、データが平均からずれればずれるほど、関数の値は小さくなることになる。 つまりガウス分布は平均値の近くのデータには大きな数が対応し、離れれば離れるほど小さな数が対応する関数である。 これは実際の実験データの集合の性質をよく表す。 ガウス分布を実際に計算すると次のような曲線が得られる。

図2 ガウス分布

このような分布は実験データや自然界のあらゆる所に現れる。 全てとは言えないが、非常に多くのデータがこのようなガウス分布をする。 それは逆に言えば何かの実験をして、できる限り精度のよいデータを集めようとしても、どうしてもガウス分布してしまい、平均値の周辺にばらつくデータしか集めることしかできないということでもある。 最後に、様々な平均値と分散に対応するガウス分布の具体的な形を見ることができるアプレットを貼っておく。

アプレット1 ガウス分布のアプレット

図中の青い曲線がガウス分布を表す。meanは平均、deviationは分散の英語である。それぞれアプレット内のテキストボックスから半角で好きな数に設定することができる。数字でなかったり、分散に0を設定しようとしたら始めの設定に戻る。calculateと書かれているボタンを押せば今の設定の平均と分散でガウス分布を計算し直す。

実際に様々な平均や分散でガウス分布がどうなるのかを見て欲しい。 平均がガウス分布の最も高い部分になり、分散が大きくなれば分布が広がり、逆に小さくなれば平均周辺に鋭い山ができることを見て欲しい。

ごらんのように、ガウス分布は平均と分散さえ決めれば全体の形が決まる関数である。 これは何を意味しているかというと、ある平均と分散を持つ実験データの集まりは、それがどんなデータの集まりであれ、その平均と分散を使ってガウス分布を計算して得られる釣鐘型に分布するということである。 ガウス分布はデータの平均と分散だけで形が決まるので、もしも実験データの分布がガウス分布するならそうならなければならない。 もちろんその実験データがガウス分布しない性質を持っていればそうはならないが、大抵の場合はガウス分布するので確かに実際のデータの分布の仕方と計算によって求めたガウス分布が一致する。

ちなみに実際のデータのヒストグラムとガウス分布を比べるには、計算で得られたガウス分布に実験データの数を掛ける必要がある。 それはガウス分布は1回の実験で得られるデータがどの数になるかの確率を与えるからである。 例えばデータが20になる確率が5%だったら、100回実験すれば5回は20というデータが出てくる可能性が高い。 それは100×0.05=5だからである。 同じように、ガウス分布がその数をデータとして取る確率を与えるなら、実際のヒストグラムはガウス分布と実験データ数の掛け算になる。

14.2 具体例

14.2.1 落体の法則

それでも地球は回っていると言った人の実験

これからは実際に様々な実験をして実験データを集め、統計を使って法則を発見していく。 まず始めに落体の法則について調べる。 むかしむかしイタリアのあるところにガリレオ・ガリレイという科学者がいて、ピサの斜塔から重い物と軽い物を同時に落として、どちらも同時に地面に落ちることを発見したという逸話がある。 それを実際に自分でやってみようということである。

用意するのはいくつかの硬貨とストップウォッチである。 硬貨とストップウォッチを手に持ち、床の上に立って首を曲げて真下を向き、目のすぐ前から硬貨を落とし、落としたのと同時にストップウォッチで時間を測り始め、硬貨が地面に落ちた瞬間に止めて目の高さから地面に落ちるまでにどれくらい時間がかかったのかを調べる。 これなら自分の目は常に下を向いていて、硬貨が落ちていくのを真上から見下ろすことになるのでいつ硬貨が地面に落ちたのか分かりやすい。 目の高さはほぼ一定であり、一定の距離を落ちるのにかかる時間が硬貨の重さに寄らず同じならば、重い物も軽い物も同時に落ちることが言える。 硬貨は10円硬貨、1円硬貨、10円硬貨をテープで4枚まとめたもの、1円硬貨をテープで4枚まとめたもの、の4種類を用意した。 実際に自分でやってみた実験データは次の通りである。

| 硬貨の種類 | 1回目 | 2回目 | 3回目 | 4回目 | 5回目 | 6回目 | 7回目 | 8回目 | 9回目 | 10回目 |

|---|---|---|---|---|---|---|---|---|---|---|

| 10円硬貨4枚 | 50 | 51 | 59 | 51 | 50 | 56 | 52 | 59 | 56 | 58 |

| 10円硬貨1枚 | 51 | 60 | 60 | 52 | 54 | 54 | 52 | 60 | 55 | 58 |

| 1円硬貨4枚 | 54 | 55 | 51 | 58 | 56 | 53 | 55 | 54 | 55 | 57 |

| 1円硬貨1枚 | 59 | 57 | 54 | 56 | 58 | 55 | 59 | 61 | 54 | 60 |

(単位は1/100秒)

全体的に見てどの硬貨も50から60までの間に収まっており、硬貨の重さによって落下するのに必要な時間は変化しないことが分かる。 データ全体の平均は55.5になり、分散は9.75になる。 全てのデータがおおむね平均値の周囲に散らばっているのが分かり、この実験はまずまず信頼のおける実験であることが分かる。 つまり落体の法則は正しいことが分かる。

モデルは現実ではない

それはいいのだが、今特別に注意して説明したいのは実験のやり方そのものである。 私は自分で実際に実験を行い、落体の法則が正しいことを確かめた。 しかし、どうしてこの実験でそれを確かめることができたのだろうか? 的外れな実験では法則を導くことはできないのだから、この実験が何か落体の性質について本質的な部分を引き出したことになる。 そのことについてもう少し考えてみる。

今の実験で求めたいのは落体の法則である。 落体の法則は重力しか働いてない物が自然に運動したとして、重い物も軽い物も同じ運動をするという法則である。 だが、今用意した実験では、空気抵抗があるから重力しか働いていないという状況ではない。 しかも硬貨の大きさの違いによって空気抵抗は変わってくるはずなので、これは実験結果をおかしくする要素になりえる。 しかし今の実験ではその差はほぼ影響を与えないで済んでいるようである。

今の実験で最もデータのばらつきに影響を与えているのは、おそらくストップウォッチを自分の手で止めたりしているところだろう。 目や音を聞いてから指でストップウォッチを押すので、指や耳の反応の速さが実験の精度を決める。 なんといっても、0.50秒程度の時間の間に2回もボタンを押さなくてはならないので、指を正確に動かすのが大変で、若干のずれが起こる。 硬貨を落とすのと同時にストップウォッチをスタートさせるのも、若干ストップウォッチの方が早かったり、硬貨を落とすのが早かったりする。 100分の1秒の違いを測定しているのだから、もちろんこれもデータのばらつきに影響する。

また、首を曲げて下を向いた状態から硬貨を落とすとしても、足の開き方や背中の曲げ方首の曲がり方などによって床との距離が変わる。 距離が変わればもちろん落ちるまでにかかる時間は変わる。 他にも床の凸凹や、微妙なそよ風など、ありとあらゆる要素が実験データに影響を与える。 このような様々な影響が合わさって、実験データをばらつかせる。

私達はこのようなデータをばらつかせる要素をすべて無視している。 目の高さから硬貨を落として落ちるのにかかる時間を測る、という実験は、このような少し考えれば分かるような要素をすべて無視して行っている。 こうして、確かに区別できるのに、それをあえて無視して作った状況のことをモデルと呼ぶ。 落体のモデルなので、いうなれば落体モデルということになる。

さて、この落体モデルの特徴を説明する。 落とす人の目の高さはいつも同じなので、この落体は常に同じ高さから落ち、空気の抵抗や影響を受けず、必ず真下に落ち、落下時間は正確に測ることができる、という特徴をもっている。 落体の重さはどんな重さでもいい。 そういう特徴を持ったモデルを考え、現実の状況をそのモデルにあてはめている。 これはまさに現実に対する模型である。 例えば飛行機のミニチュア模型を作るとして、普通は外見だけを再現して中身は空っぽにする。 もちろん中身の機械も再現すればより精巧な模型にはなるが、それはかなり難しい。

同じように現実の落体の細かい違いを無視すれば今考えている落体モデルになる。 このモデルは頭の中で考えた物であり、概念の中にしか存在しない。 現実の状況は落とす高さもばらばら、空気の影響はあるし時間は正確には測れない。 しかし、私達はこの実験の現実の状況は無視して、概念上の落体モデルを使って実験を行ったとしてデータを扱うことになる。 モデルを正確に現実で再現することはできない。 もしモデルを完璧に再現することができれば、実験データはばらつくことはないが、現実はモデルを再現できず、様々な余計な影響があるために実験データがばらつくのである。

このようなモデルという概念には注意しなくてはならない点が一つある。 それは一言で言ってしまえば、モデルは現実ではないということに尽きる。 著者が実際に行ったのは、いくつかの硬貨を自分の目の高さから落とし落ちるのにかかった時間を測る実験である。 その結果落ちるのにかかる時間の平均は0.555秒だという結果を得た。 これは実際にやってみた結果なのだから、確かに正しい法則になる。 つまり、著者がいくつかの種類の硬貨を自分の目の高さから落として落ちるのにかかる時間を測ったら、平均して0.555秒だという結果を得る、という科学法則は正しい。 これは、「著者がいくつかの種類の硬貨を自分の目の高さから落として落ちるのにかかる時間を測る」という原因と、「それが平均して0.555秒になる」という結果からなる科学法則である。

これはもちろん正しい科学法則であり、何度やっても同じ結果が得られる。 少なくとも、最終的に得られる平均値が0.555秒と比べて大きくずれることはない。 しかしこんな科学法則が得られたところで何も面白いことはない。 最も問題なのがこの法則は著者が実験した時に何が起こるかという法則であり、読者が同じような実験をしたときに何が起こるかについて何も言っていない。 この法則が著者にしか当てはまらないのであれば、それを文章にして人に読ませたところで読者が得られる物は何も無い。

この問題を解決し、今見つけた科学法則を広く一般に当てはまる便利な科学法則にするために使うのがモデルなのである。 今作った落体モデルでは、落体は著者の目の高さから落ちるのではなく、ある一定の高さから落ちる、ということになっている。 これならばその一定の高さを再現すればいいので、誰が実験しても当てはまる法則になる。 そして著者が実際に行った実験は、著者が作り出した特別な状況ではなく、モデルを現実に再現して実験を行ったと扱うのである。 そうすれば読者も今作った落体モデルを自分で再現しさえすれば、著者が得たのと同じ結論を得ることができる。

しかし実際に得られたデータはあくまでも、著者が著者の目の高さから現実に存在する硬貨を落として測った結果である。 概念の上の落体モデルそのものを再現して実験を行ったわけではない。 にも関わらず、私達はこの実験から落体モデルにあてはまる法則を導き出した。 ここには明らかな理論展開の穴がある。 この論理の穴が小さいうちは問題は起こらないが、それが大きくなると現実とかけ離れた結論を導くようになる。

例えば硬貨ではなくちり紙を落として同じ実験をやってみたとする。 ちり紙では落ちるまでにひらひら舞って、とてもではないが0.5秒前後で地面に落ちるとは考えられない。 また、地面に落ちるまでの時間もかなりばらばらになることだろう。 こういった実験をしたにも関わらず、今作った落体モデルを再現して実験を行ったとしてデータを扱えば、現実とはかけ離れた結論を得るだろう。

モデルを使って科学法則を導く場合、常にこのような危険をはらんでいる。 実際の実験の結果を限界を超えて一般化したモデルに当てはめてしまい、おかしな結論を得たり、モデルを実験で再現したと思っていたのに、実は重要な点が抜けていて再現できておらず、おかしなデータを得たりすることがある。 こういう時はモデルは所詮モデルであり、現実ではないのだということを思い出さなくてはならない。 そして現実をモデルに近づけるなり、モデルを改良して現実に近づけるなりしなくてはならない。

実験データはガウス分布する

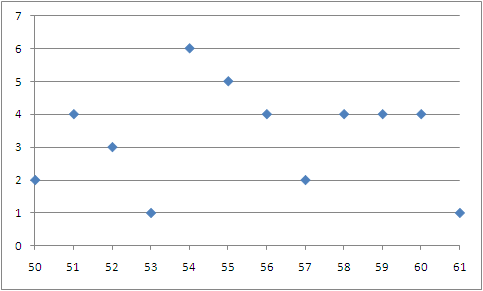

このように、この実験データは今作った落体モデルを完全に再現して得たデータであると扱っている。 もしも実験でモデルの状況を完全に再現すればデータはばらつかないが、実際にはそんなことは無理なのでデータはばらつく。 理屈の上では概念上の落体モデルで得られるデータがばらつくことになるが、このばらつきは実際にはモデルに組み込まれていない要素が引き起こす誤差である。 それがどのような分布になるのかを調べるためにヒストグラムを書いてみると、次のようになる。

図3 落体の法則の実験のヒストグラム

最も多くの回数出てくる数は54で6回出てくる。 次に多いのは55で5回出てくる。 平均が55.5なのだから、このあたりに山があり、そこから離れるに従ってその数を取るデータの回数が減るのは納得のいく結果である。 53と57の出てくる回数が少なく、51の60出てくる回数が多いが、このような分布の偏りは実験データの数をどんどん増やしていけば消えて、最終的にはきれいな釣鐘型になると期待できる。 確かに実験データはガウス分布に近い分布をしているように見える。 それが分かりやすくなるように、ヒストグラムにガウス分布を書き入れると次のようになる。

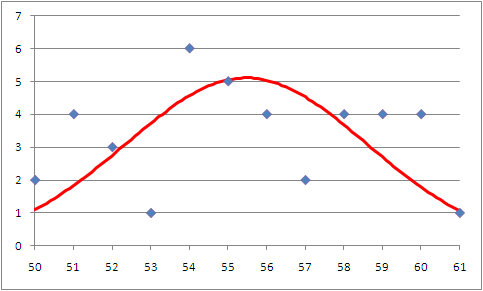

図4 落体の法則の実験のヒストグラムとガウス分布

赤い曲線は平均55.5、分散9.75の時のガウス分布を40倍したものである。 つまり、

f(x)=40/(√2π・3.12)・e-(x-55.5)2/(2・9.75)

である。 これはガウス分布を表す式であるf(x)=1/(√2π・σ)・e-(x-μ)2/2σ2の、μに55.5、σ2に9.75、σにσ2の平方根である3.12を代入したものに40を掛けたものである。 なぜ40を掛けるかといえば、ガウス分布は1回の実験でそのデータがそこの数値を取る確率を表すので、40回の実験を行い40個のデータがあるなら、40回の実験のうちその数値を取ると期待できる回数は1回の実験でその数値を取る確率に40を掛けることによって得られるからである。

さて、それでは実際の実験データとガウス分布から確率的に計算される分布の様子を見てみる。 やはり53や57のデータが気になるものの、他の部分ではかなりガウス分布を表す曲線に近い値になっているのがわかる。 まず目につくのが、52、55、58、61のデータがほぼ完全にガウス分布から予測される回数と同じ回数現れていることである。 他にも50、54、56、59のデータはガウス分布から予測される回数と比べて1回多いか1回少ない範囲の回数で現れている。 これを誤差の範囲と考えると、実に50から61までの12種類のデータのうち、8種類の場所でガウス分布による予想と一致する結果となっている。 この実験データは意図的に作ったのではなく、著者が自分で実際に実験して得たデータであるので、これは驚くべき結果である。

ガウス分布からの予想とずれているのは51、53、57、60であるが、ここも、もし51の回数が2回少なく、その分53が2回多く、同じように60が2回少なく、57がその分2回多く現れれていたとしたら、すべての数が誤差の範囲に収まることになる。 そう考えれば、このヒストグラムは非常にガウス分布に近く、もう少しでガウス分布に完全に一致するところだったことが分かる。 このように、実験データの分布はガウス分布で説明がつく場合が多い。

さて、せっかく苦労して実験をやったり統計を取ったりしたのだから、最後にこのデータを使って何か新しい情報を引き出したい。 物が一定の重力の中で落下するとき、落下距離をyとして、落下時間をtとすると、

y=gt2/2

という関係が成り立つ。 gは定数で重力加速度と呼ばれている。 単位はm/s2になる。 なので、もしyとtの値が分かれば重力加速度を求めることができる。

実験では目の高さから硬貨を落としているので、その距離を実際に測ってみると1.31mだった。 もちろんこの長さは実際に実験をやった時には各データごとにばらばらである。1cmもずれることはないだろうが、1mm程度なら必ずずれがある。 だが、私達はこれらのデータを私達が作ったモデルを完全に再現して行った実験によって得られたものだと扱っている。 なのでどのデータも硬貨が落下し始めた高さはすべて1.31mで一致しているとして扱う。

そして落下にかかる時間はばらつくが、その平均は0.555秒であることが分かっている。 この平均値も多分に誤差を含んでいるはずだが、モデルの中では正確な数であることになっている。 さて、落下距離と落下時間が分かったのだから、重力加速度を求めることができる。 y=gt2/2を変形するとg=2y/t2になる。 これにy=1.31とt=0.555を代入すると、

g=2×1.31/(0.555)2

=8.51

となる。 もっと精確な実験によって求められた重力加速度の値は9.81m/s2なのでその差は1.30m/s2になる。 なので現実と比べて約13%ほど小さな値を見積もったことになる。 これを大きなずれと見るか小さなずれと見るかは人によると思うが、著者自身としてはこんないい加減な実験で結構正確な数値が得られたと満足している。

14.2.2 アクセスランキングの法則

アクセスは指数的に減少する

インターネット上では沢山のウェブサイトが存在する。 このサイトもその一つである。 そしてそういった沢山のサイトが登録しているランキングサイトというものが存在する。 ランキングサイトでは沢山のサイトに順位をつけランキングにして並べている。 そしてランキングサイトの上位になればそのランキングサイトを見ている人がそのサイトを読みに行くことになる。 これらのランキングの何位にいるかと、どれだけの人が読みに行くかの関係を知るのはサイト製作者にとってとても関心のある問題である。 ここではその関係を見つける。

その法則を見つけるために実際のランキングサイトを調べた。 このランキングサイトは登録しているサイトにこのランキングサイトへのリンクを貼り、そのリンクが一日に何回クリックされたかを数え、その回数が多いほど上位にランクされるようになっている。 そのランキングサイトの1位から10位までに入っているサイトにどれだけアクセスがあるかを5日間調べた。 結果は次のようになった。

| 順位 | 1日目 | 2日目 | 3日目 | 4日目 | 5日目 | 平均 |

|---|---|---|---|---|---|---|

| 1位 | 4640 | 4700 | 4900 | 4680 | 4280 | 4640 |

| 2位 | 6040 | 6090 | 6260 | 5890 | 5240 | 5904 |

| 3位 | 3720 | 3740 | 3980 | 3810 | 5690 | 4188 |

| 4位 | 4790 | 4850 | 5050 | 4900 | 3690 | 4656 |

| 5位 | 3330 | 3350 | 3280 | 3040 | 2770 | 3154 |

| 6位 | 3720 | 3740 | 3770 | 3530 | 3280 | 3608 |

| 7位 | 2920 | 2980 | 2990 | 1150 | 1810 | 2370 |

| 8位 | 1100 | 1070 | 2290 | 1850 | 1150 | 1492 |

| 9位 | 2270 | 1790 | 1910 | 2090 | 450 | 1702 |

| 10位 | 1780 | 2300 | 1210 | 2810 | 2030 | 2026 |

さて、このデータからなんらかの法則を導くために平均値のグラフを描いてみる。

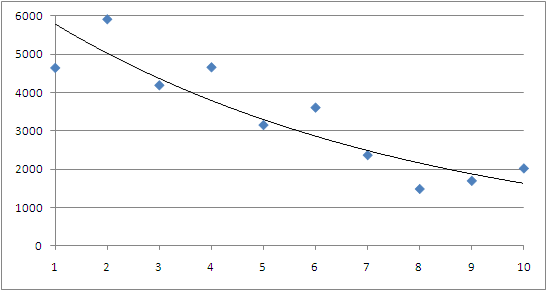

図5 アクセスランキングの順位とアクセス数の関係

横軸は順位、縦軸はアクセス数

青い四角がデータであり、グラフに書き入れてある黒い線はデータの間をなめらかに結んだ線である。 この線は直線というよりも曲線に見える。 そしてこの手の曲線は変数が大きくなるに従って0に近づいて行っているので、1/xとかe-xのような曲線になる。 ひとまず、あてずっぽうでe-xだと当たりをつけてみる。 もしこの曲線がe-xという関数であれば、データの対数を取れば直線になるはずである。 つまり、順位をx、そのxの時のアクセス数をyとしたら、aとCという定数を用意して、

y=Ce-ax

という様に表されるとしたら、その対数をとれば、

logy=logCe-ax

=logC+loge-ax

=logC-ax

となるということである。 もし、logyをグラフに描いたら、それはxを変数としてlogCをx軸との交点、-aを傾きにした直線になる。 それでは実際にlogyを計算し、それをグラフに描いてみると次のようになる。

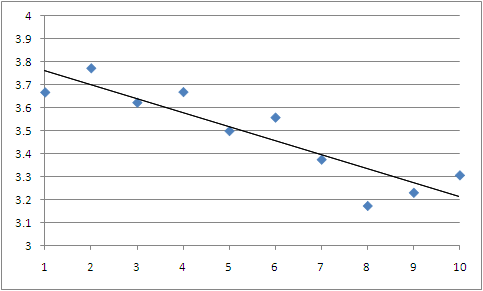

| 順位 | y(平均) | logy |

|---|---|---|

| 1位 | 4640 | 3.667 |

| 2位 | 5904 | 3.771 |

| 3位 | 4188 | 3.622 |

| 4位 | 4656 | 3.668 |

| 5位 | 3154 | 3.498 |

| 6位 | 3608 | 3.557 |

| 7位 | 2370 | 3.375 |

| 8位 | 1492 | 3.174 |

| 9位 | 1702 | 3.231 |

| 10位 | 2026 | 3.307 |

図6 アクセスランキングの順位とアクセスの関係

横軸は順位、縦軸はアクセス数の対数

グラフを見る限りではきちんとデータは直線上に並んでいるように見える。 よってアクセスランキングの順位が大きくなるほど、アクセス数は指数的に少なくなることが分かる。 ちなみにこれで直線が得られなかったら、今度は1/xのような関数ではないかと当たりをつけて、逆数を計算して直線になるかどうか調べる。 このように、とにかく結果を当てずっぽうに予測して、もしそうだったらこういうグラフが直線になる、というデータの処理方法を見つけ、実際にグラフ描いてみて予想が当たっているかどうかを試し、当たるまでひたすらこの手順を繰り返していくという手法は、結構有効な手法である。

ランキングサイトでこのような傾向があるのならば、同じようにサイトを上から順に並べていくような場所でも同じようなアクセス数の変化があることが期待できる。 となると、普通の検索エンジンでは検索ワードに一致する検索結果を上から順に順序付けて並べるので同じように指数的なアクセス数の減少があることが期待できる。 もし一般的に検索エンジンからのアクセス数が検索結果の順位に対して指数的に減少するのであれば、できるだけ多くのアクセスが欲しいサイト製作者としては、検索結果の順位を上げるのに腐心しなければならないことになる。

さて、今発見したのは実在のランキングサイトの順位とアクセス数の関係である。 その結果、順位が下がるほど、つまり順位の数字が大きくなるにつれて指数的にそのランキングサイトからのアクセス数が減ることが分かった。 法則の信頼度を増すためにもっと沢山のランキングサイトのデータを取ったり、長い時間に渡ってデータを取ったりすればなお良い結果が得られるだろう。 これは実際に実在のランキングサイトのアクセス数を調べて見つけた、単なる事実である。 ランキングサイトのアクセス数を見たら、下に行くに従って指数的に減っていくというのは、単なる事実である。

だが実はまだこれだけでは、ランキングサイトの上位に入れば大量のアクセスが得られるとは言い切れない。 なぜなら、この法則はなぜアクセス数が指数的に減るのかについて何も説明していないからである。 つまり、ランキングサイトの順位が高いからアクセス数が多いのか、もともとアクセス数が多かったからランキングでも順位が高いのか、どちらなのか、これだけでは分からないのである。 データがそのような傾向を示す理由を説明するためには理論モデルを組み立てたり、その理論モデルから予想される新しい法則を実験で確認したりなど、非常に困難な検証が必要になる。 それなしである事実に勝手な思い込みから解釈を与えてしまうのは、原因と結果を履き違える可能性のある危険な行為である。

14.2.3 収穫加速の法則

私達が夢を見てもいい理由

ここでは技術の発展の仕方についての重要な法則である収穫加速の法則について説明する。

説明する内容はすべて以下のページに書いてあるのでこれを読んでもらえばいいのだが、長い上に英語で書かれているので、重要な点だけをかいつまんで紹介しようと思う。

The Law of Accelerating Returns March 7, 2001 by Ray Kurzweil

昨今の情報技術の進歩の速さは驚くべきものがある。 次から次へと新しい製品が出て、どんどんコンピュータの計算速度は速くなるし記憶容量も増える。 コンピュータ業界におけるこのような進歩の速さは何も今に始まったことではなく、実は昔からそうなのである。

1965年のアメリカで、ゴードン・ムーアというコンピュータ開発の第一人者が次の事実に気づいた。

私達は24ヶ月ごとに集積回路の中のトランジスタの数を倍にできる。

これは2年ごとにコンピュータの計算能力を倍にできるということである。 これは実際に彼がこのペースで集積回路を開発してきた経験からこのような法則を発見したのだろうと思う。 2年で倍になるのだから、4年経てば4倍になり、6年経てば8倍になる。 単純に考えれば20年経てば1024倍になるということである。 そんな単純に話が進むわけがないだろうと思うかもしれないが、実はこの単純な話が情報産業全体で2010年現在までずっと続いている。

1950年でのCPUの計算能力を10としたとき、1960年でのCPUの計算能力は数十になり、1970年には数千になり、1980年には数万になり、1990年には数百万になり、2000年には数億になっている。 50年間で計算能力は1000万倍になったということである。 平均すると10年ごとにCPUの計算能力は25倍になってきたということになる。 10年で25倍になるなら、20年で625倍、30年で15625倍、というようにどんどん大きくなっていき、50年で1000万倍になるということである。 これはRAMの記憶容量でも似たようなことが起こっており、1975年以来、18ヶ月ごとに記憶容量は倍になってきている。 これは1.5年で倍になるということだから、10.5年で128倍になってきたことを意味している。

また、インターネットホストの数は1980年には数百程度だったのに5年で数千に増え、1990年には数十万に増えている。 その後も約5年ごとに10倍に増えていっている。 単純に考えるとこれはインターネットの情報量や普及率が毎年1.6倍になっていることを意味する。 毎年倍とまでは言わないまでも、今ある規模の半分を毎年増やしていることになる。

このように情報産業において、いたるところで数年のうちに能力を倍にするという成長が見られる。 数年で倍になり、またその次の数年でその倍になるのだから、元の4倍になる、といった成長が見られる。 このように、元の倍で増える状況を指数的に増えるという。 情報産業はもう50年間以上も指数的成長を続けてきたという実績がある。

ここまでで実に分かりやすい情報産業の指数的成長については理解してもらえたと思う。 さて、これを聞いて、情報産業とはそのような指数的成長をする特別な分野なのだと言って話を終えてしまったのでは、あまり面白くない。 収穫加速の法則とは、成長とはそもそもこのような指数的な成長をするものだとし、全ての分野で指数的成長が見られるという法則である。 例えば精密な機械を作る能力なども指数的な成長を遂げているし、DNAを解析する機械の性能、人間の脳をスキャンする技術なども指数的な成長を遂げている。 様々な例を調べれば、このような指数的成長はいたるところに見つかることだろう。

さて、以上述べたようなことが上記のリンク、The Law of Accelerating Returnsに書かれている。 いくつかのグラフを見れば言葉で読むよりも収穫加速の法則について実感を得られると思う。

収穫加速の法則とは、人類は指数的に成長するという法則である。 さて、果たしてこの法則はどれだけ信頼に足るのだろうか? 半導体産業が半世紀もの間、指数的成長を遂げてきたというのは単なる歴史的事実である。 これは疑うべくもない。 そして他の分野についても指数的成長が見られる分野があることも単なる事実である。

普通、過去50年間ずっとこうだったと言われれば、次の50年間もずっとそうなのではないかと考える。 そしてもし過去50年間に起こったことが次の50年間にも同じように起こったとしたら、2030年ごろに人間の能力を超える性能を持ったコンピュータが誕生することになると期待されている。 人間を超えるというのは、人間のあらゆる活動、物を見分けたりそれを過去の記憶と照らし合わせて何であるか認識したり、音楽を聴いたり言葉を理解したり、突然熱いものに触れたら手をひっこめたり、起きている間も寝ている間も心臓を一定のペースで脈打たせたり、といった全ての活動を人間の脳ではなくコンピュータで情報処理してなお計算能力に余りが出るという意味である。 そんなコンピュータが誕生したら、漫画の世界で描かれていた鉄腕アトムやドラえもんのような、人間のようなロボットを作ることも夢ではないだろう。 そして宇宙に行ったりタイムトラベルしたりといった、めくるめく冒険の日々が始まる。

さて、果たして本当にこれからも指数的成長は続くのだろうか? 過去50年間、計算機は指数的成長を遂げてきた。 人類の歴史をよく観察すれば、いたるところに指数的成長が見られる。 収穫加速の法則は人類が歩んで来た過去についてはよく当てはまる。 しかし、まだ未来については分からない。 成長にはおのずと限界というものがある。 本当にこれからも指数的成長を維持するのだろうか? 収穫加速の法則の通り、人類はこれからも指数的成長を遂げるのだろうか?

様々な要因が指数的成長の妨げになるだろう。 資源の枯渇、技術的な限界、社会的な障害、ありとあらゆる問題が山積みになっている。 これらの問題を一つ一つ解決していき、未来を切り開いていかなくてはならない。 収穫加速の法則がどれだけ正しい法則なのかによって、人々の生活はまったく違ったものになる。 この問題は今、最も注目されるべき問題である。

もどる